V prvej časti som sa venoval panike, ktorá sa zbytočne šíri a ideologizácii klimatických zmien. V tejto časti popíšem ako sa robia klimatické modely, prečo ich je tak veľa, prečo sa tak líšia v predpovediach a či sú dôveryhodné.

V prvom rade si treba uvedomiť, že akékoľvek predikcie môžu byť urobené s ako-takou vedeckou spoľahlivosťou len na základe modelov reality. Aj predpoveď, že keď zhodím z balkóna vajce, tak sa po určitom krátkom čase na zemi rozbije, je na základe modelu, v ktorom beriem do úvahy gravitačnú silu, ale ignorujem aktuálnu hustotu vzduchu, veľkosť žĺtka a bielka a podobne, pretože toto má minimálny vplyv na čas pádu a žiaden na výsledok experimentu.

Klimatológia je interdisciplinárna veda - zahŕňa meteorológiu, atmosférickú chémiu, oceánografiu a pod. Nárast počtu klimatológov s nástupom Billa Clintona a hlavne viceprezidenta Ala Gora bol podľa meteorológa Linzena spôsobený znásobením zdrojov do klimatológie (nenašiel som však k tomu reálne dáta). Od 90-tych rokoch minulého storočia sa však klimatológia zameriave takmer výlučne na potvrdzovanie globálneho otepľovania.

Základom predpovedí sú modely založené na rozdelení Zeme na menšie oblasti. Tieto oblasti sú potom delené na vrstvy a každej takejto bunke zodpovedá jedna sada klimatologických dát. Vnútorné procesy prebiehajúce v priebehu jednotlivých cyklov sú pre tieto vzduchové hmoty alebo a bunky v moriach nejako aproximované. Rôzne údaje priradené k týmto bunkám potom slúžia ako vstupy pre ďalší krok výpočtov nielen pre aktuálnu bunku, ale aj všetky susedné bunky.

Ako fungujú klimatologické modely

Klimatické modely sa teda snažia popísať interakciu vzduchových hmôt navzájom, vzduchu a zemského povrchu, vzduchu a vody ako aj vnútri hlavne povrchových vrstiev morí a oceánov (pozri napríklad toto video).

Povrch Zeme sa rozdelí na podobne veľké plochy a potom na vrstvy (napríklad podľa atmosférického tlaku) - v ďalšom texte ich budem označovať ako bunky. Pred 15 rokmi bola veľkosť bunky 110 km, dnes sú regionálne modely s veľkosťou bunky 2,2 km, avšak globálne modely sú na úrovni 50km. Ďalším rozmerom je vertikálne delenie. Rôzne modely používajú rôzny počet vrstiev atmosféry a oceánov.

Posledným rozmerom je čas. Modely počítajú údaje za rovnaké časové obdobie, ktoré je ale v nejakej miere závislé od veľkosti bunky. Ak nejaký jav má ovplyvniť len susedné bunky, tak ten časový interval nemôže byť príliš veľký, na druhej strane príliš malý interval znamená príliš veľa cyklov výpočtov a nemusí prispieť k presnosti výsledkov.

Modely sa líšia aj v algoritme, ktorý pre každú bunku zo vstupných údajov vypočíta výstupné. Iniciálne vstupy by mali byť merania fyzikálnych javov reprezentujúcich bunky. Popri tom ešte máme vstupy závislé od času, napríklad množstvo CO2.

Nie je bunka ako bunka

IPCC pri OSN vydal k reportu za rok 2007 dokument o modeloch. 23 modelov, používalo značne odlišné veľkosti buniek od 50 km po 280 km. Štvrtý report IPCC však zároveň priznáva, že je obtiažne overiť presnosť modelov voči minulým dátam, lebo tieto sú neúplné. Napriek tomu to robí, ale rozdiely oproti meraniam po roku 1990 (keď už mala zrazu mať klimatická zmena vplyv - na druhej strane pred rokom 2000 sa teploty oceánov vôbec nemerali a potom spôsobom, že niektorá loď nabrala vedro vody, odmerali tam teplotu a to bola teplota za 20 000 000 km2 časti oceánu) považuje za nepodstatné.

Aj v rámci správy o modeloch píšu (kap. 8.2.2.2) o pozorovaní zlepšenia simulácie morských prúdov, keď morské bunky mali veľkosť 1/3° (33km), kým ostatné 1° (100km). Problém je, že z tých 23 modelov bolo mnoho veľmi nepresných (280km) a málo ich malo presnejšie rozlíšenie pre vodu ako vzduch.

Avšak v prípade vody a vzduchu je tu jeden zásadný rozdiel. Na zohriatie 1 metra na povrchu morí o určitú teplotu je potrebné toľko tepla ako na zohriatie 5 km vzduchu o tú istú teplotu. Vzduch je 800x ľahší na hladine mora a 1200x ľahší vo výške 5000m a voda má 4x vyššiu mernú tepelnú kapacitu.

Pokiaľ máme nepresné a presné modely, tak ich spriemerovaním dostaneme horší výsledok ako keby sme použili len presné modely.

Čo má spĺňať klimatický model

V minulom zamestnaní som programoval predpovedný model predaja výrobkov na základe jednoduchých matematických výpočtov (linárenej regresie). Realita nakupovania je zložitejšia, povedzme že to zjednodušíme na to, že určitý tovar si zákazník v čase t1 presunie do košíka a v čase t2 ho zaplatí na pokladni. Model postavený na zaznamenávaní predaja výrobkov pokladňou (čas t1 by sa dal zistiť len veľmi ťažko) vedel s pomerne malou presnosťou upozorniť na príliš veľký interval od posledného predaja daného výrobku. Toto mohlo indikovať, že tovar nie je vyložený na pultoch. Avšak takýto model mal príliš veľa falošne pozitívnych výsledkov.

Na druhej strane nepresnejší model, ktorý iba sčítal množstvo predaných výrobkov za deň/týždeň, dokázal pomerne presne (teda s malou rezervou) predpovedať spotrebu do budúcna. Hoci to nebol najpresnejší model (pracoval na úrovni dní alebo týždňov), jeho predpovede boli presné práve preto, že súčty a priemery majú menšie odchýlky.

Aj teploty majú veľmi oscilačný charakter, dokonca aj dňové priemery, avšak napríklad už mesačné priemery sa od seba líšia málo. Takže hoci aj klimatické modely nemusia presne popísať zložitú fyziku javov v atmosfére, oceáne či na ich hraniciach, môžu byť postačujúce pre odhad priemernej teploty.

Konvergencia

Pokiaľ spresňujem model (počtom delení zemského povrchu alebo zmenšovaním časovej zložky), mal by som dostávať presnejšie výsledky. V matematike je konvergencia presne definovaná, ale keďže matematika je teoretická veda predpokladá, že pre každé n viem povedať hodnotu f(n). Ak funkcia konverguje, viem k požadovanej presnosti ε nájsť hodnotu N, od ktorej bude f(n) najviac ε ďaleko od hodnoty, ku ktorej funkcia konverguje (limity).

V prípade klimatických modelov je tu problém, že neviem povedať, aký výsledok bude mať model s rovnakým algoritmom pri delení na veľkosť bunky 50 metrov.

Najsilnejšie superpočítače používaných napríklad v NOAA počítajú modely s presnosťou 50 km (10 km v oceánoch) až 10 a viac dní (štandardne sa počíta predpoveď od roku 1990 po rok 2100, za jeden deň takýto počítať predpovie 11 rokov).

Ľudstvo pravdepodobne nebude nikdy schopné spočítať model s veľkosťou bunky 500 metrov (100 m v oceánoch), pretože dosiahneme maximálne výkony procesorov (pozri nižšie).

Preto vedci robia, aspoň to, čo sa dá, teda skúmajú či modely s bunkami veľkosti 1° (110km) konvergujú.

Napríklad v článku z roku 2015 skúmali vplyv časovej zložky. Model s rôznymi časovými intervalmi od 2 s po 30 min. nechali spočítať 1 hodinu (do roku 2100 pritom ostáva viac ako 670 000 hodín). Zistili, že odchýlka v teplote pri kroku 1/2 hodiny bola 0.1°C a pri kroku 2s (900x presnejšom) 0.01°C. Prekvapilo ich, že skracovanie času nezlepšuje adekvátne presnosť modelov.

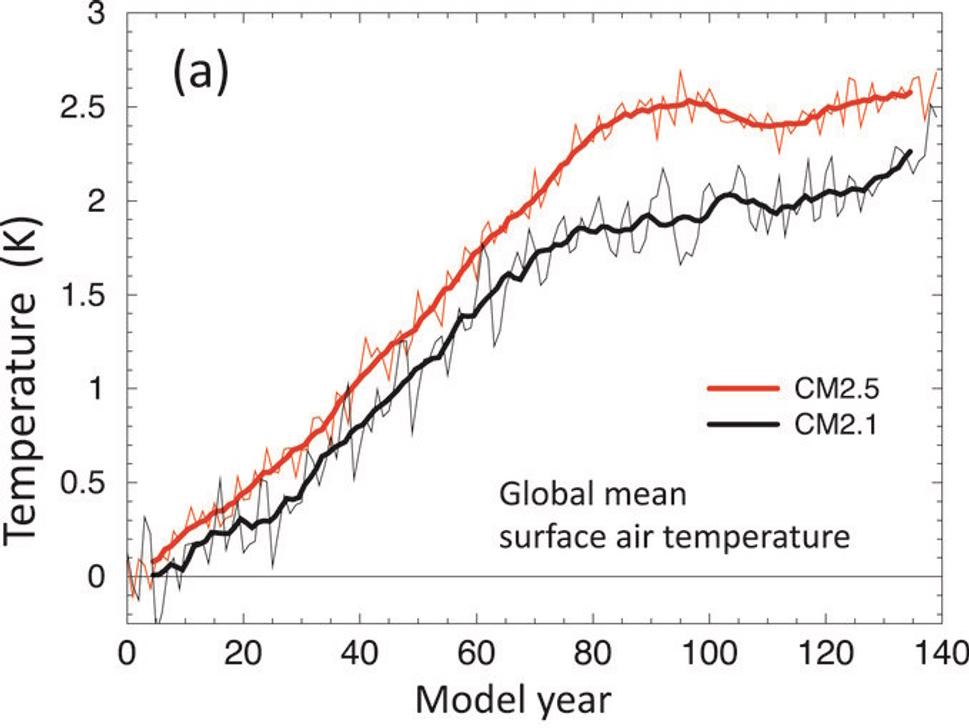

Pred desiatimi rokmi (2012) vyšiel vedecký článok, ktorý porovnával vtedy najpresnejší model CM 2.5 s jeho predchodcom CM 2.1. Výsledok je, že medzi modelmi je veľmi značný rozdiel. Model CM2.1 mal veľkosť bunky 220 km pre atmosféru a 110 km pre oceán, zatiaľ čo model CM 2.5 má veľkosť bunky pre atmosféru 55 km a pre oceán 25 km (4x menšia strana, čiže 16x viac buniek). Aktuálny model CM 2.6 má zachovanú veľkosť bunky pre atmosféru (55 km), ale veľkosť bunky pre oceán je len 0,1° (teda asi 11km).

Pri teplote atmosféry bol novší model pesimistickejší o 0,5 °C, pri teplote oceánov o 0,02 °C. Netuším ako prišli na to, že od roku 2027 po rok 2029 (a potom znovu medzi 2080 - 2084) sa ochladí priemerná teplota Zeme o 0,5°C (model CM2.5 má tiež značné skoky).

Konzistentnosť

Ďalšou vlastnosťou modelu by malo byť, že výsledky (nielen priemernej teploty, ale aj regionálnych priemerných teplôt, zrážok a pod.) sa budú veľmi málo líšiť v závislosti od výberu delenia povrchu Zeme, pokiaľ počet a veľkosti buniek budú rovnaké. Čiže, ak máme bunku veľkosti 50x50 km (vertikálne vrstvenie ostatne zachované), tak by malo byť jedno, či toto delenie posuniem o 1 km na západ, alebo 1 km na východ.

Nenašiel som však žiadne výsledky ohľadom kontroly konzistentnosti modelov vzhľadom na výber mriežky.

Testovateľnosť

Tak ako pri akejkoľvek vede, každé tvrdenie musí byť falzifikovateľné, teda v prípade modelov, musíme vedieť povedať, že model je zlý.

Preto musí dávať aj konzistentné výsledky a mať aj malú odchýlku, pretože ak model povie, že do roku 2030 sa oteplí o 0 až 5°C oproti priemeru 1850-1900, tak takýto model je nanič. Zároveň to ale znamená, že modely použité pri reportoch IPCC spred desiatich rokov by sa už mali dať porovnať s realitou.

Presnosť

Najdôležitejšie je pomocou testovateľnosti overiť spätne, že model naozaj popisuje realitu. Znamená to zbehnúť výpočet nie za roky 1990 - 2100, ale za roky 1900 - 2020 a potom porovnať napríklad priemerné teploty rokov 2010-2020 (nie za celý svet, ale za určité menšie klimaticky homogénnejšie oblasti) voči realite.

Niečo takéto pred piatim rokmi urobili v tomto článku a ukazuje sa, že hoci sa modely (prvý z roku 1973) v odhade oteplenia líšia niekedy až o 30%, v zásade potvrdzujú triviálny fakt, že vyššie CO2 (už násobne oproti predindustriálnej dobe) znamená vyššiu teplotu.

Na grafoch porovnávajúcich model s "realitou" je zaujímavé, ako veľmi sa líši priemerná teplota vypočítaná NOAA od priemernej teploty vypočítanej NASA (a sú tam aj trošku väčšie rozdiely pri iných zdrojoch). Napríklad pre rok 2017 je to až 0,07°C a to je viac ako medzi priemernou predpoveďou štvrtého a piateho reportu IPCC. Keď teda nevieme aká je realita, ťažko vieme, ako dobré sú klimatické modely.

Samozrejme presnosť overuje aj IPCC pri OSN, akurát to, že modely nevedia vysvetliť niektoré javy (El Niño), nie je pre nich dôvod na nezahrnutie modelu do priemeru pre výsledný report.

Navyše je tu problém s dátami, pretože ako som už spomínal pred piatimi rokmi, merania teploty oceánov sú extrémne nepresné.

Použitie satelitných meraní teplôt narážalo na odpor, lebo nevychádzalo dostatočné oteplenie. V roku 2017 sa však vedcom podarilo upraviť spätne dáta zo satelitov tak, aby ukázali vyšší nárast teploty. Potvrdzuje to, že metodológia zberu satelitných dát v minulosti bola chybná (možno technické obmedzenia?), pretože to, že satelit prejde nad rovníkom v inom čase (povedzme o 6 večer a nie na poludnie) neznamená, že inde nebolo meranie práve opačné (miesto o 6 ráno zbieral dáta na poludnie). Satelity však nekrúžia po poludníkoch (napríklad NOAA-19 z roku 2009 obehne Zem za necelé 2 hodiny a sklon má 98° - tu je jeho aktuálna poloha) a už vôbec nie po rovnobežkách, takže na meranie teploty Zeme satelitmi sú zrejme nutné aj dodatočné úpravy.

Štvrtý report IPCC (2007) v spomínanej kapitole 8 uvádza zvýšenie dôvery v presnosť predpovedí modelov, pretože niektoré (aspoň 2) pri použití idealizovaných scenárov dokázali zahrnúť vplyv sírovodíkových aerosólov. Ďalej keď vhodne inicializovali asimiláciu oceánskych údajov, dokázali niektoré (teda aspoň 2) s mierou úspechu popísať aj El Niño. Záver je, že každý model má slabiny a preto neexistuje najlepší model a treba zobrať do úvahy viac modelov. To však umožňuje vybrať to najhoršie a šíriť klimatickú paniku (a zvášiť financie na svoje výskumy klimatických zmien).

Piaty report IPCC (2014) v kapitole 9 uvádza napríklad: Simulácia oblakov v modeloch zostáva výzvou ... chyby sú v rádoch desiatok wattov na m2 (priemer je okolo 1000 W hlavne v závislosti od uhlu dopadu slnečných lúčov). Väčšina modelov nevie reprodukovať zníženie otepľovania za posledných 10-15 rokov ("Most simulations of the historical period do not reproduce the observed reduction in global mean surface warming trend over the last 10 to 15 years."). No a nakoniec, opäť neexistuje najlepší model a nevieme, ktorý model je ako dobrý, tak zoberieme všetky ("In general, there is no direct means of translating quantitative measures of past performance into confident statements about fidelity of future climate projections. ... However, there is still no universal strategy for weighting the projections from different models based on their historical performance")

Šiesty report IPCC (2021) ani nemá kapitolu, kde by uvádzal klimatické modely. Keď si do google dáte climate model evaluation ipcc ar6, tak sa dostanete len k starším reportom. Hoci som si neprečítal 2212 stránok reportu (zvyšných 179 sú indexy a terminológia), z tých 17 výskytov spojenia climate model evaluation som predsa len v reporte nejaké informácie našiel (hlavne v indexe).

Keď už teda používam cherry-picking - na strane 475 sa píše, že od piateho reportu majú veľa indikácií, že na modelovanie oceánov je potreba vyššie horizontálne rozlíšenie. Možno preto majú niektoré modely veľkosť oceánskej bunky na úrovni 11 km (vyššie spomínaný CM2.6), pričom atmosféra ostáva na úrovni 55 km alebo 100 km. Avšak je to dostatočné?

Vstupné dáta

Nakoniec do hry vstupujú dáta, ktorými algoritmus kŕmime. Ide o statické dáta, iniciálne dáta a dynamické vstupy počas behu.

Statické dáta sú vlastne popisom Zeme - kde sú aké vysoké hory, kde sú jazerá, moria, aké hlboké sú moria.

Iniciálne dáta sú napríklad morské prúdy, teplota, tlak, tie isté, ktoré počíta model pre každú bunku.

Môžu tu byť ale aj dáta, ktoré algoritmus nepočíta ako vstup ďalšieho kroku, ale občas ich tam systém (rozumej vedec, ktorý spúšťa simuáciu) zmení. Napríklad množstvo CO2 alebo iných plynov. Práve ľudská činnosť ovplyvňuje množstvo CO2 a nemožno preto odvodiť jej hodnoty z predchádzajúceho stavu.

Šiesty report IPCC pri OSN popisuje výsledky modelov pre rôzne množstvá CO2 v atmosfére. Práve táto informácia je kľúčová pre výber riešení, avšak budem sa jej venovať až v ďalšej časti série.

Aké modely používa OSN ?

IPCC pri OSN pri svojom piatom reporte z roku 2014 používa asi 50 rôznych klimatických modelov, ktoré sú uvedené v tabuľke 9.1 na stránke 747. Farba určuje kategóriu podľa počtu buniek pre atmosféru a pre oceán.

Iba 5 z 50 modelov (všetky americké) má veľkosť bunky pre atmosféru menšiu ako 100 km a pre oceán menšiu ako 70km. Čiže sa dá povedať, že OSN predpovedá tak, že k 5 žiakom so známkami 3 pridá 45, ktorí prepadajú a urobí z toho priemer.

Aby som nebol len kritický a neuzavrel tému tak, že predpoveď, v ktorej je atmosféra nad Slovenskom reprezentovaná 1 alebo 2 sadami hodnôt raz za hodinu, je nanič, pozrel som sa na tie presnejšie z klimatických modelov.

Klimatické modely od NOAA

Americká agentúra NOAA je najväčšou na svete, najlepšie financovanou, má najlepší hardware, a preto je schopná poskytovať modely s lepšou presnosťou ako ostatní. Na stránke https://nomads.gfdl.noaa.gov/ sú popísané klimatické modely

Aby som pochopil, aké náročné je vykonať výpočty modelov, vyhľadal som články o počítačovej komplexite výpočtov klimatických modelov a našiel som tento článok z roku 2017. Vedci spúšťali rôzne klimatické modely na rôznych superpočítačoch a merali, ako dlho trvá výpočet simulácie. Hodnoty vyjadrili v čase potrebnom na simulovanie 1 roku (bežne prebieha simulácia 110 rokov).

Môžeme mať dosť presný model?

Najpresnejší model CM2.6 mal už spomínanú veľkosť atmosférickej bunky 55 km a oceánskej asi 11 km (oproti modelu 2.5, ktorý mal veľkosť oceánskej bunky 1/4° - asi 27 km). Spomínaná štúdia zameraná na náročnosť výpočtov porovnávala 18 rôznych klimatických modelov s rôznou komplexitou na rôznych superpočítačoch. Počet buniek bol od 3,6 milióna po 490 miliónov, čo pri 80 a viac vrstvách znamená priemernú horizontálnu veľkosť bunky od 11 km po asi 100km.

Komplexita bola od 18 premenných (CM2 modely) po 144 (IPSL-CM6-LR S).

Keďže som nenašiel dosť presný popis modelu 2.6, pozrel som sa na verziu 2.5, ktorá má zhruba 5x menší počet buniek (83 miliónov). Oceánske bunky sú od 28 km pri trópoch po 8 km pri vyšších zemepisných šírkach a majú 50 vertikálnych vrstiev. Atmosférické bunky majú veľkosť asi 50 km a 32 vrstiev. To je spolu 6,5 mil. atmosférických pri kroku 30 minút a 77 mil. oceánskych buniek pri kroku 20 minút. Na výpočet 1 roku simulácie potrebujeme spočítať zhruba 1,1*10^11 atmosférických a až 2*10^12 oceánskych výpočtov.

To čo simuluje dianie v atmosfére v oblasti 50 km x 50 km x 100 m v priebehu 30 minút sú zložité, ale reprezentované 18 hodnotami na vstupe a 18 hodnotami na výstupe. Obsahuje komplexné výpočty, ale predpokladá správanie sa, ktoré nemusí byť vôbec presné.

Rôzne modely sú viac či menej komplexné a tento jeden výpočet trvá rôzne dlho. Spolu to napríklad na superpočítači s takmer 80 tisíc jadrami trvalo viac ako 2 hodiny. Čiže za sekundu zvládol spočítať 270 000 000 bunko-krokov. Bežný stolový počítač s 6-8 jadrami by zvládol teda zhruba 30 000 bunko-krokov za sekundu. Netuším samozrejme, či novšie modely nemôžu byť výpočtovo menej náročné aj pri väčšej komplexite, skôr by som očakával opak.

Môže pomôcť grid-computing?

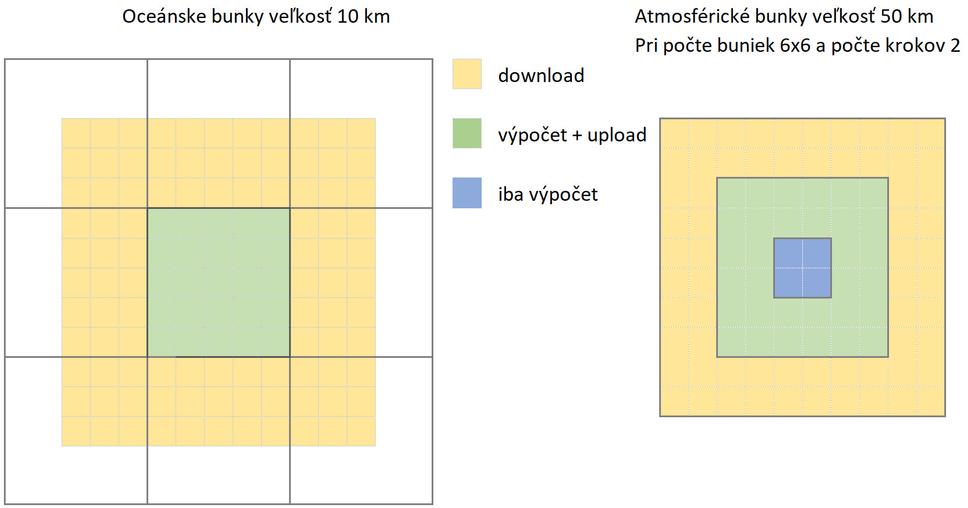

Ak by sme chceli distribuovať simuláciu na viacero počítačov, je potrebné, aby si predávali informácie za okrajové oblasti. Možno tiež počítať oceánske bunky zvlášť od atmosférických, vtedy si musia posielať informácie za vrchné/spodné vrstvy. Keďže oceánskych častí je o rád viac ako atmosférických, tieto budú najviac ovplyvňovať dobu trvania výpočtov, atmosférické výpočty tom pridajú tak dvadsatinu.

Súčasný značne nepresný model by potom pri použití len asi 150 000 lepších stolových počítačov mohol byť porovnateľný s výpočtom na superpočítači. Ak by každý uzol počítal jeden 15 minútový krok za oblasť 0,5° x 0,5° oceánov (25 štvorcov a 50 vrstiev), tak pri rýchlosti 30 000 bunko-krokov za sekundu by to bolo len 40ms. Avšak po svojom kroku by sa musel zosynchronizovať so susednými oblasťami, čo znamená download dát z asi 4 800 buniek (po 30 minútach, teda za 2 cykly sa atmosférické dáta ovplyvňujú do hĺbky 0,5°, čo ale pri oceánskych je 5 oblastí v každom smere. Preto po 15 minútach potrebuje dáta z 3 oblastí v každom smere, čiže 121, z ktorých 25 má, lebo ich práve spočítal. 96x50 = 4800).

Takže hoci výpočet by na uzle takejto siete trval len 40ms, potom by nasledoval download možno 0.5 MB a upload asi 100 kB dát (za predpokladu nízkej komplexity - iba 100 bajtov dát na bunku), čo pri latencii siete ešte navyšuje čas pre jeden krok. Navyše nie je možné začať ďalší krok, kým nie sú spočítané susedné bunky a dáta musia byť aj šifrované. Toto robí výzvu použiť 150 000 počítačov zložitejšou, pravdepodobne by museli byť dáta počítané duplicitne a veľká časť celkového času by bolo čakanie, kým budú dáta k dispozícii.

Ak by to ale všetko sadlo, tak výpočet klimatického modelu CM2.5 pri veľkosti buniek 50 km a 10 km a intervale 30 a 15 minút na 150 000 stolových počítačoch s dobrou sieťou (aspoň 100 Mbit) by pre obdobie 1990-2010 trval len 7 a pol dňa, pričom na vyššie spomínanom superpočítači to bolo 10 dní.

Štúdia počítala aj energetickú spotrebu - na superpočítači bola spotreba na 1 rok simulácie asi 0,8 GJ = 0,22 MWh. Pri 150 000 počítačoch by to bolo 150 MWh na rok simulácie, čiže asi 3 rády.

Problém je, že výsledok je aj tak veľmi nepresný.

Ak by sme išli s presnosťou na 2-násobok, potrebujeme k tomu aspoň 8x väčší výpočtový výkon (horizontálna presnosť implikuje temporálnu, ale pravdepodobne bude treba aj zvýšiť počet vrstiev). Čiže, aby sme išli na 8 násobnú presnosť (7 km miesto 55km), znamená to, že by bol potrebný 500 násobný výpočtový výkon. Ak by naďalej platilo Moorovo pravidlo, tak to nastane po 18 rokoch. Ale asi ani najväčší optimisti nepredpokladajú, že Moorovo pravidlo bude ešte dlho platiť - odhad je do roku 2025.

Je preto pravdepodobné, že modely na úrovni 1km pre atmosféru a 200m pre oceán (tam už naozaj nebude stačiť 50 vrstiev) nebudeme nikdy vedieť spočítať. Aj meteorologické modely ako napríklad Aladin používaný SHMU idú len na úroveň 10 km za oblasť strednej Európy a počítajú predpoveď na 10 dní (á ta je na 1 deň je ako tak presná). A to im trvá pár hodín (denne vyprodukujú 4 predpovede).

Ak by sme to chceli urobiť dnes (s 1 minútovým krokom pre atmosféru a 30 sekúnd pre oceán), tak počet celkový operácií sa znásobí 65 000 krát. Superpočítač by tak simuláciu 1990 - 2100 nepočítal desať dní, ale 1800 rokov, pričom by sa zrejme časom rozpadol. Aj v prípade, že by sme v roku 2040 mali superpočítač s 1000 násobným výkonom, výpočet by bežal takmer 2 roky.

V prípade výpočtu pomocou siete počítačov by dnes bolo treba príliš veľa počítačov. Ak by každý počítal zhruba 4 km x 4 km, tak by bolo potrebných 22 miliónov počítačov, ale trvalo by to len 3 roky.

V roku 2040 za predpokladu 1000x vyšších výkonov by pri počte počítačov asi 1,6 milióna (každý by počítal 15 km x 15 km) výpočet trval len dva týždne.

Záver

Vyzerá to teda, že nebude možné mať modely, ktoré budú počítať iné klimatologické premenné pre Lomnický Štít ako Veľký Slavkov (vzdialený 12 km). Rovnako niektoré meteorologické javy sú veľmi rýchle - napríklad hurikány, ktoré sa pohybujú rýchlosťou v priemere 25 km/h, ale v zasiahnutých oblastiach majú rýchlosť vetra 200 km/h. Je podstatný rozdiel či je výpočet v čase prechodu hurikánu alebo 15 minút po ňom.

Hoci meteorologické modely s podstatne vyšším rozlíšením predpovedia počasie ako-tak presne na 1 deň, v prípade klimatických modelov a ich výstupov ide o priemerné hodnoty. A tak ako bude priemer sto striel do terča skoro presne stred aj keby ste boli zlý strelec, tak aj tieto modely nemusia byť nepresné vo svojich výstupoch. Ani klimatológovia však nevedia porovnať, ktorý model je lepší, takže potom možno robíme priemer s niekým, kto nemieril vôbec na stred terča.

Napriek tomu nič lepšie ako modely pre odhad budúcnosti nemáme. Iba malá skupina odborníkov sa môže relevantne vyjadriť k samotným algoritmom a predpokladom rôznych klimatických modelov, ktoré vďaka nízkej granularite musia viac vecí o správaní sa atmosféry a morí predpokladať. Modelom dnes už vedia nastaviť parametre tak, aby sa ich výpočty zhodovali s určitými meraniami v minulosti, avšak hlavne v oblasti dát z oceánov (teplota, salinita, morské prúdy) ide o varenie z vody.

V ďalšej časti sa tak pozriem, ako Bjørn Lomborg s použitím akceptovaných výstupov klimatických modelov publikovaných v reportoch IPCC, ako aj ekonomických modelov odporúča pristupovať k problémom vysokých emisií CO2 a ich predpokladaným dôsledkom na klímu.